はじめに

ITのなかではすごく広い括りのなかでも注目すべきはAIと感じ、今後もAIが様々な業種と結びついていく世の中になっていくと思います。そんな中で現在のAIを作り上げているディープラーニングについて記事にしてみました。

ディープラーニングとは

まず、ディープラーニングは、人間の脳のニューロンの動作を模倣したニューラルネットワークを基にした機械学習の一種です。これは、大量のデータからパターンを学習し、予測や分類などのタスクを達成するためのモデルを生成します。

ニューラルネットワークとは

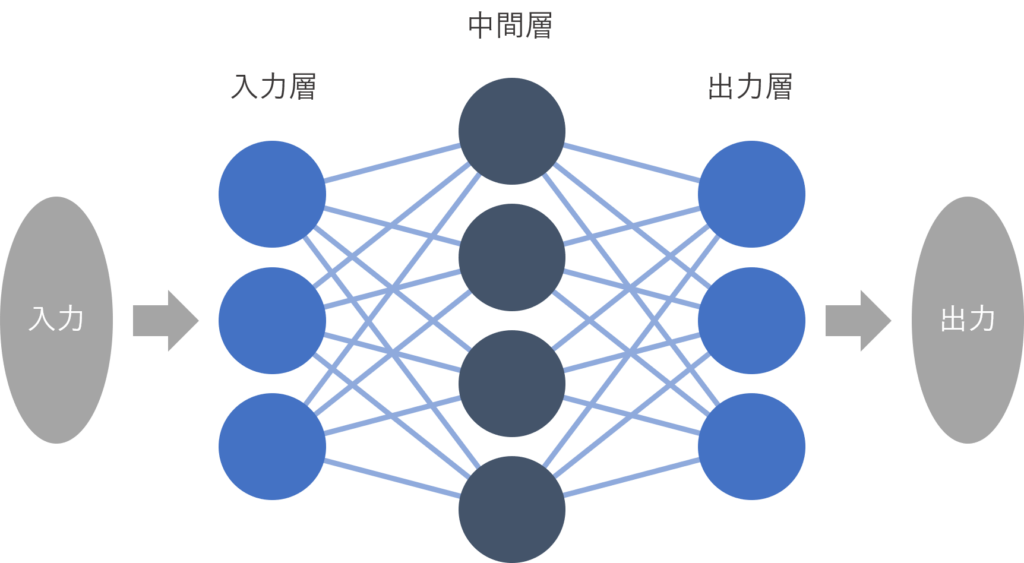

人間の脳神経系のニューロンを数理モデル化したもので、機械学習や深層学習の関連技術として広く知られており、その具体的な内容は入力層、出力層、中間層(隠れ層)の3つの層から構成されていて、その流れは入力層でデータを受け取り、中間層(隠れ層)にてノード(ニューロン:イメージは囲碁の石)で複雑(線でつながる)に組み合わさり、出力層で結果を出力する構造になっています。そしてこれらの構造が何層にもなって存在しているのがディープラーニングの核になっています

簡単に言いますとディープラーニングは人間の脳の一部の構造を模倣している構造です。

ディープラーニングにおける重要な概念

- ニューラルネットワーク:脳の神経回路網をモデル化した数学的モデルで、入力層、隠れ層、出力層から構成されます。

- ニューロン(ノード):ニューラルネットワークの基本単位であり、入力を受け取り、それに対する重み付きの合計を計算し、活性化関数を通して出力します。

- 活性化関数:ニューロンの出力を非線形に変換する関数で、一般的にはシグモイド関数、ReLU(Rectified Linear Unit)、ステップ関数などが使われます。

- トレーニング(学習):ニューラルネットワークに大量のデータを与えて、そのデータに適合するように重みを調整するプロセスです。

- バックプロパゲーション:誤差を最小化するようにニューラルネットワークの重みを調整するアルゴリズムで、出力層から逆向きに誤差を伝播させます。

これらの概念がディープラーニングの基礎を構成しています。この他にも、畳み込みニューラルネットワーク(CNN)、再帰型ニューラルネットワーク(RNN)、強化学習など、さまざまな派生があります。

活性化関数について

- 活性化関数は、ニューラルネットワークの内での値を次のニューロンにどのように出力するかを決める

- この関数を使用することで、複雑な計算を行うことができる。

- 活性化関数を使う目的は、「表現の自由度を上げる」ことです。つまり、より複雑な問題を解決できるようにすることです。

活性化関数の種類と概要

代表的な活性化関数の種類を紹介します

- ステップ関数: 閾値を超えたら1、それ以外は0を出力します。

- シグモイド関数: 0から1の範囲で滑らかな曲線を描きます。

- ReLU関数 (Rectified Linear Unit): 正の値はそのまま、負の値は0を出力します。

- Softmax関数: 複数のクラスの確率を出力する際に使用されます。

- 恒等関数: 入力をそのまま出力します。

他にも関数は存在します。

ディープラーニングにおける重み

- ニューラルネットワーク(ディープラーニングの基本構造)は、複数の層(レイヤー)から成り立っています。

- 各層は、複数のノード(ニューロン)から構成されており、それぞれのノードは入力データに対して重み付けを行います。

- 重みは、ノードが入力データにどれだけ影響を与えるかを制御するパラメータです。

- ニューラルネットワークは、これらの重みを学習することで、問題に適した特徴を自動的に抽出します。

ディープラーニングの歴史

- パーセプトロンの登場:

- 1958年にフランク・ローゼンブラットが最初に提唱したのがパーセプトロンです。

- パーセプトロンは、事前に決められた出力を実現するためのパラメータを入力に合わせて推定するアルゴリズムでした。

- このアイデアは神経生理学的研究から得られたニューロン(神経細胞)の人工的モデルに基づいています。

そして注目され始めたのは、2000年代後半から2010年代にかけてで、これは大量のラベル付きデータと強力な計算能力が利用可能になったためです。つまり時代がある程度追いついたからできたものだったんですね。とするとこれから処理速度やハードウェア、クラウドなどが発展していくとさらに人の脳に最も近いものが作られる可能性が近い将来できそうですね。

ここが起源とされているみたいですが参考までに。ただこんなにも前から人の脳を模した存在を作ろうとなったのがここまで形になっているのが驚きです。

ディープラーニングのアルゴリズム

- バックプロパゲーション(Backpropagation):誤差逆伝播法とも呼ばれ、ニューラルネットワークの重みを調整するためのアルゴリズムです。出力層から逆向きに誤差を計算し、それを使用して各層の重みを更新します。

- 確率的勾配降下法(Stochastic Gradient Descent, SGD):ニューラルネットワークの最適化アルゴリズムの一つで、誤差を最小化するために重みを調整します。ランダムに選択されたサブセット(ミニバッチ)のデータを使用して勾配を推定し、それに基づいて重みを更新します。

- Adam:Adaptive Moment Estimation(Adam)は、SGDの一種であり、学習率を調整しながら勾配の移動平均を計算することで効率的に最適化を行います。Adamは一般的に高速で収束性が良いとされています。

- 畳み込みニューラルネットワーク(Convolutional Neural Network, CNN):画像認識などのタスクに特化したニューラルネットワークアーキテクチャで、畳み込み層とプーリング層から構成されます。

- 再帰型ニューラルネットワーク(Recurrent Neural Network, RNN):系列データ(例:テキスト、音声)に適用されるニューラルネットワークで、過去の情報を記憶する能力を持ちます。時系列データ処理に適している。

- LSTM(Long Short Term Memory):RNNの一種で、長期的な依存関係を学習できるアルゴリズム。時系列データの長期的なパターンを捉えるのに有効です。

- GAN(敵対的生成ネットワーク):生成モデルであり、偽物を本物に近づけるためのアルゴリズム。画像生成やデータ拡張に利用されます。

- Dropout:過学習を防ぐためのアルゴリズム。ニューラルネットワークの一部のユニットをランダムに無効化することで汎化性能を向上させます

畳み込み層とプーリング層について

畳み込み層 (Convolutional Layer):

画像認識や物体検出などのタスクで広く使用される層です。画像などの位置関係が重要なデータに対して、位置情報を保持したままニューラルネットワークにデータを流す役割を果たします。

プーリング層 (Pooling Layer):

物体の位置が変動しても同一の物体であるとみなす役割を持つ層です。畳み込みで得た特徴を最大値や平均値に要約することで、位置の変化に対して頑健な特徴を得るための処理です。

これらのアルゴリズムはディープラーニングにおいて広く使用されており、それぞれ異なるタスクや問題の用途に適しています。また、これらのアルゴリズムの発展形や派生形も存在します。

ディープラーニングの応用例

- 画像認識:畳み込みニューラルネットワーク(CNN)を使用して、画像内のオブジェクトやパターンを識別するために利用されます。顔認識、物体検出、画像分類などがこれに該当します。

- 自然言語処理(NLP):再帰型ニューラルネットワーク(RNN)やトランスフォーマーなどのモデルを使用して、テキストデータの言語モデリング、機械翻訳、感情分析、質問応答などのタスクを実行します。

- 音声認識:ディープラーニングを用いて音声信号をテキストに変換する音声認識システムがあります。リカレントニューラルネットワーク(RNN)や、その変種である長短期記憶ネットワーク(LSTM)がよく使用されます。

- 医療診断:医療画像の解析や病理学的特徴の予測にディープラーニングが活用されます。例えば、X線画像やMRIスキャンからの疾患の検出や診断支援が行われます。

- 自動運転:ディープラーニングを組み込んだセンサーデータの処理や物体検出、経路計画などが自動運転技術に応用され、自律走行車の開発に役立っています。

- 金融取引予測:ディープラーニングを用いて株価や為替レートの予測、不正取引の検出、信用リスク評価などが行われます。

ディープラーニングの課題と未来

ディープラーニングは非常に強力なツールですが、まだ解決すべき課題があります。これには、モデルの解釈可能性、データのプライバシー、そしてバイアスの問題が含まれます。しかし、これらの課題にもかかわらず、ディープラーニングはAIの未来を形成する重要な要素であり続けるでしょう。

進むだけでなく倫理などの課題は数多く議論されています。今後どうなっていくのかは少しずつAIとの共存する世の中になって人の生活の便利な存在となるように発展させつつそれと並行に決まりを作っていくしかないと思います。

おわりに

ディープラーニングの内容についていろいろまとめてみました。AIを学ぶということは、人の脳を学ぶのと同じことですね。しかしディープラーニングはニューラルネットワークの一部ということは。人の脳はさらに複雑になっているのだと考えると奥が深いですね!

読んでいただきありがとうございました。